-

Les constructeurs chinois de smartphones se mettent à leur tour à moquer les derniers iPhone présentés par Apple. Xiaomi et Huawei ont ainsi chacun à leur manière taclé le géant américain Apple.

Samsung a pris l'habitude de se moquer gentiment d'Apple dans ses publicités. Les fabricants chinois, eux, viennent tout juste de sauter le pas et d'adopter cette méthode. En effet, Xiaomi et Huawei se sont amusés chacun de leur côté à titiller Apple au moment le plus critique : lors de la présentation des nouveaux iPhone. Ils s'en prennent respectivement au manque d'innovation des iPhone et à leurs prix élevés.

Huawei est le premier à avoir dégainé, avec une vidéo publiée dans un tweet le soir même de la keynote d'Apple. On pouvait y lire : "Merci de faire toujours la même chose, on se retrouve à Londres le 16 octobre." Sans spécifier qu'ils parlent bien d'Apple, il est clair que le fabricant chinois s'adresse au géant américain. Notons, car c'est assez cocasse, qu'en lisant les commentaires de ce tweet les internautes n'ont pas oublié la "triche" de Huawei sur les selfies et les faux benchmarks de son futur téléphone, le Mate 20.

Du côté de Xiaomi, la méthode est plus subtile. La marque s'est mise à vendre — en Chine uniquement — des packs regroupant un ordinateur, un téléphone, un bracelet connecté ainsi que des écouteurs pour le prix de chaque iPhone. Le fabricant a même nommé ses packs de façon explicite : Pack XS Max, Pack XS et Pack XR. Un pied de nez à Apple pour montrer que pour le prix d'un téléphone Apple, Xiaomi propose beaucoup plus qu'un smartphone. C'est de bonne guerre.

votre commentaire

votre commentaire

-

Des clichés d’un supposé Samsung Galaxy A7 ont fuité sur le net. Ils montrent un appareil doté d’un triple capteur photo.

Comme nous vous l’expliquions il y a peu, Samsung aimerait introduire ses innovations sur les appareils milieu de gamme avant de les intégrer sur les familles S et Note. Un bon moyen, selon le coréen, de séduire les millenials qui n’ont pas le même pouvoir d’achat.

C’est dans cette optique que la firme pourrait intégrer des processeurs Snapdragon 845 sur le prochain Galaxy A7. Mais ce n’est pas tout. Le site néerlandais Galaxy Club explique avoir récupéré des rendus presse du smartphone et ces derniers montrent la présence d’un triple capteur photo en haut à gauche de la face arrière.

Ce type de capteur est pour l’instant destiné aux appareils haut de gamme et il serait donc étonnant de le retrouver sûr du milieu de gamme. Précisons toutefois que le prix du A7 n’est pas encore connu, et que toutes ces nouveautés seraient intéressantes à condition que le tarif reste contenu.

Le reste est assez classique puisque l’on aperçoit un écran au ratio 18 : 9 et un revêtement bleu ou noir qui ressemble à du verre. Le site précise qu’il pourrait embarquer 4 Go de RAM et un SoC Exynos 7885 mais ces informations restent à prendre avec des pincettes.

On devrait en savoir plus dès le 11 octobre prochain lors d’un événement spécial nommé « 4x Fun ». Le nombre exact de capteurs présent sur le A7…

votre commentaire

votre commentaire

-

Le déballage de l’Apple Watch a toujours été une véritable expérience, pensée comme telle par Apple. Le packaging de l’Apple Watch Series 4 ne fait pas exception à la règle, d’ailleurs la Pomme a complètement revu la boîte ! Celle-ci est maintenant emballée dans un carton qui se déplie de manière tout à fait spectaculaire, comme le montre iJustine dans sa vidéod’unboxing.

Mais ça n’est pas tout ! Le boîtier de l’Apple Watch est livré dans un petit étui de protection, quant au bracelet qui accompagne la montre, il est fourni… à part, dans son propre emballage. Voilà qui est plutôt singulier, mais peut-être que cela aidera à mieux gérer les stocks. Ou qu’Apple va permettre d’acheter un boîtier seul, accompagné du bracelet de son choix…

votre commentaire

votre commentaire

-

La GeForce RTX 2080 sera disponible dès demain, la RTX 2080 Ti, dans une semaine. Il est grand temps de voir si elles ont dans le ventre de quoi tenir la promesse de performances jusqu’à 50 % supérieures à celles des GTX Séries 10.

C’est l’heure de vérité pour les cartes graphiques Nvidia GeForce RTX 2080 et RTX 2080 Ti. Après leur lancement le 20 août dernier en marge de la GamesCom et les multiples présentations techniques que nous avons eu la chance de suivre, nous en attendons beaucoup et il est temps de pouvoir entrer dans le vif du sujet. Les premiers utilisateurs devraient en effet pouvoir mettre la main sur la RTX 2080 dès demain.

La valse des Cores

Les promesses faites par Nvidia sont très alléchantes et reposent sur une architecture complètement repensée. On y trouve encore plus d’unités de calcul CUDA Cores, des niveaux caches remaniés et/ou agrandis et un GPU Boost (version 4.0) dont le comportement a été modifié. Pour plus de détails, nous vous renvoyons à l'article A lire ci-dessous.

Impossible de ne pas mentionner l’arrivée des unités Tensor Cores et RT Cores sur le circuit, un héritage de l’architecture professionnelle Volta. Elles vont être en charge d’améliorer le rendu des jeux vidéo existants et à venir. A condition qu’ils soient optimisés, bien évidemment. Pour tout savoir sur leur rôle et la façon dont ils sont censés embellir nos jeux, reportez-vous à notre article A lire, ci-dessous.

Bilan, avec toutes ces innovations, Nvidia est catégorique : les RTX peuvent se révéler deux fois plus puissantes que leurs aînées.

Des démos de jeux pour le DLSS, pour le RTX pas encore

Les RTX sont des cartes graphiques tournées vers le futur. En effet, actuellement, il n'y a pas de jeux complets qui soient compatibles DLSS ou RTX à se mettre sous la dent. Même Shadow of the Tomb Raider, qui fait partie des premiers jeux optimisés pour les deux technos et sorti depuis le 14 septembre dernier, n'a pas encore bénéficié des mises à jour nécessaires. Vous voyez où nous voulons en venir : impossible de tester ces deux nouvelles technologies dans des titres que nous connaissons déjà.

Toutefois, Nvidia se devait de montrer les muscles ! Le concepteur a fourni à la presse deux démos qui utilisent le DLSS, la première est celle de Final Fantasy XV et la seconde, celle de Epic Infiltrator.

Nous avons ainsi pu faire un début de comparatif entre un rendu utilisant du TAA (Temporal Anti-Aliasing) et du DLSS, aussi bien d'un point de vue visuel que de celui des performances pures, puisque nous avions quelques scores générés par les applis.

Toutefois, nous n'avions pas la main sur les réglages graphiques, ni la possibilité de les affiner à notre sauce. Nous prendrons donc les résultats ci-dessous avec des pincettes en attendant de pouvoir les reproduire nous-mêmes.

Quoi qu'il en soit, comme le montre les résultats, l'activation du DLSS ne provoque pas de pertes d'images par seconde. Au contraire. En TAA, qui mobilise uniquement les CUDA Cores pour simplifier, les RTX affichent des scores bien moins élevés que ceux que l'on peut obtenir en activant le DLSS. Cette technologie met à contribution les Tensor Cores, soulageant de fait les CUDA Cores. Ils se focalisent donc sur d'autres tâches et le nombre d'images par seconde grimpe de l'ordre de 30%, le tout en 4K, rappelons-le. Appréciable.

Sur le plan visuel - et il va falloir ici nous faire confiance - les différences sont perceptibles, les images sont un peu plus nettes et le crénelage, moins visible. Néanmoins, il faut savoir raison gardée : cela ne saute pas aux yeux du premier coup. Il faut prendre le temps de se concentrer sur certains détails, certaines images ou scènes.

Dans le cas du RTX, Nvidia nous a fourni la démo Star Wars créée en partenariat avec Unreal Engine et ILMxLab, celle qui tournait sur 4 cartes graphiques à base de puces Volta lors de sa première présentation et qui, pour le lancement des RTX a été un peu remaniée pour être prise en charge par les cartes Nvidia grand public.

Toutefois, pour en profiter, il nous aurait fallu passer en mode Developer dans Windows afin d'avoir accès à la version démo de DirectX Ray-Tracing, déjà implantée dans la dernière mise à jour de Windows 10 et dont la version finale ne sera déployée qu'avec l'October Update.

Pour des raisons de temps et dans un souci de conserver notre plate-forme stable, nous avons pris la décision de ne pas le faire. Nous attendrons donc encore un peu avant de pouvoir essayer et de nous émerveiller devant les prouesses visuelles et lumineuses du RTX. Prouesses que 4A Games, le studio en charge du développement de Metro : Exodus, a récemment mis à l'honneur dans sa dernière vidéo commentée ci-dessous.

Avant-propos et GPU Boost

Nous avons réalisé tous les tests sur notre plate-forme de référence dont vous retrouverez le détail dans notre précédent dossier sur les cartes graphiques. A ce propos, ne vous étonnez pas de ne pas trouver de cartes AMD dans ce dossier. Nous n'avons tout simplement pas réussi à mettre la main dessus pour avoir un panel complet. Toutefois, nous espérons obtenir des Vega RX 56 et 64 (et une Radeon RX 580) dans quelque temps. Si c'est le cas, nous ne manquerons pas de faire une mise à jour des graphiques.

Cependant, considérant les prestations des derniers GPU AMD face aux GTX l'année dernière, il y a peu de chances que - même avec de bons pilotes bien optimisés - les Radeon arrivent à faire aussi bien que les RTX...

Nous avons soumis les cartes GeForce GTX 1080 et 1080 Ti et RTX 2080 et 2080 Ti à nos jeux usuels, auxquels nous avons ajouté Shadow of the Tomb Raider et Assassin's Creed : Origins.

Nous n'utilisons pas toujours les mêmes jeux suivant les définitions. Dirt Rallyn'est ainsi présent qu'en 1440p et en 4K, par exemple. Par ailleurs, tous les titres sélectionnés ne sont pas visibles dans les graphiques. Ils servent toutefois à élaborer les moyennes et écarts constatés entre les deux générations de GeForce.

Avant de commenter les graphiques ci-dessous, nous préciserons quelques valeurs relevées au cours de nos tests, en matière de GPU Boost. Pour rappel, cette fréquence est donnée à titre indicatif par Nvidia, comme un minimum garanti. Mais les cartes peuvent monter plus haut, tout dépend de la qualité de la puce et de sa tolérance à encaisser les charges, tant d'occupation que de courant, etc. Nous, nous avons été gâtés.

Ainsi, sur notre modèle RTX 2080 Ti Founders Edition, la fréquence de base est donnée pour 1350 MHz et le Boost, pour 1635 MHz. Sur la RTX 2080, ces mêmes valeurs sont respectivement de 1515 MHz et 1800 MHz, selon Nvidia.

Nos deux exemplaires de tests, eux, sont parvenus à atteindre la fréquence maximum de 1935 MHz pour la Ti et de 1950 MHz pour la 2080 classique. En outre, la RTX 2080 Ti arrive à se maintenir au-delà des 1660 MHz - 1665 MHz à 1830 MHz très exactement - dans la plupart de nos épreuves, sans jamais connaître de coups de chaud (voir ci après pour le bruit, la chauffe et la consommation). La RTX 2080, pour sa part, oscille entre 1700 et 1860 MHz dans les mêmes conditions. Bluffantes.

RTX vs GTX : le match en Full HD, 1440p et 4K

Attention, avalanches de graphiques !

A la lumière des deux premiers graphiques, réunissant les relevés effectués sur les jeux en Full HD et 1440p, un constat - à chaud - s'impose. Les RTX 2080 et 2080 Ti s'ennuient ferme en Full HD et en 1440p ! Entre elles et les GTX, les écarts d'images par seconde ne sont pas très marqués dans ces deux définitions, sur les jeux actuels, The Division et Rainbow Six : Siege mis à part. Il arrive même que les GTX affichent les mêmes scores voire... de meilleurs.

Au global, la nouvelle génération l'emporte évidemment. Nous avons mesuré 10 à 12 % d'écart moyen entre une RTX 2080 Ti et une GTX 1080 Ti en Full HD (avec des pointes à 32%), et 16 et 18 % en 1440p (35 % dans certains jeux).

Pour la RTX 2080, la tendance est presque la même. En 1080p, les écarts moyens de performances sont de l'ordre de 15 % (jusqu'à 48 % max.). En 1440p, les 23% sont atteints (jusqu'à 54 % de performances en plus parfois).

Les mauvaises langues pourront dire qu'on s'attendait à mieux. Cependant, il faut rappeler deux choses. La première, les RTX se destinent clairement à être connectées à un écran 1440p (2080 et 2080 Ti), 4K conseillé (2080 Ti). La seconde, ces résultats sont aussi causés par une contrainte technique, liée à la fois aux cartes Nvidia et à notre plate-forme de test.

Notre configuration est équipée d'un processeur Intel qui commence à accuser quelques années de bons et loyaux services. On trouve à la manoeuvre un Core i7-6700K, presque identique au 7700K. Malgré ses quatre coeurs et ses huit threads à 4/4,2 GHz, il ne parvient pas à répondre à la demande des cartes graphiques RTX. Gourmandes, va !

Elles pourraient traiter beaucoup plus d'informations dans cette définition mais le processeur n'arrive pas en délivrer assez suivant les jeux. Nous sommes "CPU Limited", comme le veut le terme consacré.

C'est pour cela que les scores Full HD et 1440p sont si parfois proches de ceux des anciennes cartes graphiques. Aparté, nous avions déjà constaté ce phénomène d'embouteillage des données lors de nos tests des GeForce GTX 1080 Ti et Titan Xp mais dans une bien moindre mesure sur la première, déjà un peu plus sur la seconde.

D’ailleurs, il n’y a qu’à regarder les graphiques 4K pour se rendre compte que tout l'intérêt des GeForce RTX réside dans leur capacité à gérer l’UHD, même avec une configuration au processeur vieillissant. La RTX 2080 Ti étant clairement plus à l'aise que la RTX 2080 dans cet exercice quand il s'agit d'atteindre les 60 images par seconde. Avec de si grandes images et autant de polygones à gérer, les GPU ont beaucoup plus de travail, suffisamment pour que toutes informations envoyées par le CPU (même notre 6700K tient presque la mesure) ne s'embouteillent pas dans les tuyaux et soient traitées en bonne et due forme.

Les graphiques parlent d'eux-mêmes, les écarts sont bien plus creusés entre les deux générations de cartes, peu importe les jeux ou les tests analytiques. Ainsi, en moyenne, la RTX 2080 Ti fait 27 % de mieux que la 1080 Ti (avec des pointes comprises entre 40 et 49 % sur certains jeux), et la GeForce RTX 2080, elle, offre en moyenne des gains de 35 % par rapport à la GTX 1080 (avec des pics mesurés à 55 %).

Consommation, bruit et température

Commençons par le plus facile, le bruit. Nous n'effectuons pas de mesure au sonomètre car nous partons du principe que tous les boîtiers ne sont pas insonorisés de la même façon. Mais après plusieurs heures passées à côté des cartes torturées, nous pouvons affirmer sans mal que les nouveaux systèmes de ventilation de Nvidia sont vraiment très silencieux. C'est même assez déconcertant.

Sur la 2080 Ti, les ventilateurs dépassent de temps à autres les 2000 tours/min dans les séances de jeu musclées, sans jamais émettre le moindre vrombissement gênant. On précisera toutefois que leur vitesse de croisière se situe aux alentours de 1500 à 1700 tours/min.

Sur la RTX 2080, la ventilation atteint les 1920 tours/minute au maximum mais se situe généralement entre 1400 et 1700 tours/min, toujours dans le silence le plus complet.

Sont-ils efficaces ? Nous avons utilisé les sondes intégrées à GPU-Z pour mesurer les températures des cartes à différents moments de nos tests et, en moyenne, nous avons constaté que les 2080 et 2080 Ti plafonnaient à 75-76°C dans nos sessions 3D Mark, et 67 à 77°C lors des tests de jeux. Précisons que les cartes testées (et donc notre plate-forme) ne sont pas enfermées dans un boîtier mais sont exposées à l'air libre, dans une pièce maintenue à 25°C en moyenne. Notons enfin que tout l'air chaud est principalement expulsé vers l'intérieur du boîtier et non plus vers l'extérieur, comme avec le ventilateur de type blower des cartes Founders Edition de génération Pascal. Nous le regrettons, et nous ne serons sans doute pas les seuls.

Reste le volet de la consommation. Assez logiquement le wattmètre affiche des résultats à la hausse lorsque les RTX sont en action. Comme d'habitude, nous avons effectué plusieurs mesures et force est de constater que The Division et son gros moteur font toujours autant travailler les étages d'alimentation des cartes, plus que le test 3D Mark Fire Strike Ultra que nous utilisions en boucle pour faire chauffer et consommer les cartes graphiques il y a encore un an.

On notera toutefois qu'au repos, les nouvelles cartes de Nvidia font beaucoup plus consommer notre plate-forme de test : 30 % en moyenne. Un problème que le concepteur aurait identifié et qu'il pourrait corriger en optimisant l'algorithme dans de futures versions de pilotes. En sollicitation intense, notre plate-forme équipée de la GTX 2080 Ti est en moyenne 10 à 12 % plus vorace que lorsque la 1080 Ti est logée dans la prise PCI-E. Avec la RTX 2080, on observe jusqu'à 22 % de consommation en hausse. C'est un soupçon plus que ce à quoi nous nous attendions.

Premiers tests, premières conclusions

Nous sommes arrivés au terme de nos premières aventures avec les nouvelles GeForce RTX 2080 et 2080 Ti de Nvidia. Quelles conclusions en tirer ?

La première, c'est que si vous avez une configuration sensiblement identique à la nôtre, que vous ne jurez que par la Full HD voire le 1440p et n'avez que faire des jeux à venir ou penser que le RTX et le DLSS ne changeront pas votre vie de joueur PC... alors opter pour une GeForce RTX haut de gamme n'est pas ce que vous avez de mieux à faire pour le moment. Néanmoins, vous vous privez - en un sens - des jeux futurs et de leurs améliorations graphiques. Vous pouvez aussi attendre de voir ce que la RTX 2070 aura dans le ventre et vous décider à partir du 20 octobre prochain.

Deuxième conclusion. Si vous ne souhaitez pas passer à la 4K tout de suite mais que vous décelez le potentiel des RTX et avez envie d'en prendre plein les yeux dans les jeux qui prendront en charge le DLSS et le ray tracing, alors investir peut se justifier. Dans la 2080 pour la 1440p et dans sa grande soeur pour la 4K. Vous aurez ainsi l'assurance d'avoir accès aux prochaines technologies graphiques et de les mettre en oeuvre dans de très bonnes conditions.

Troisième conclusion, vous avez un écran 4K, la configuration musclée qui va avec et vous voulez enfin atteindre les 60 images par seconde sans faire de concessions lourdes sur les niveaux de détails. Bref, vous êtes tout à fait le genre de gamer à mettre la main sur tous les AAA à venir susceptibles de tirer parti du DLSS et du RTX ? Alors, foncez, si votre tirelire vous le permet, bien sûr.

Avant d'entamer le débat sur le positionnement tarifaire des RTX, il nous semble important de rappeler que ces cartes proposent une puce à l'architecture innovante qui est l'une des plus grosses que l'industrie ait vue. Elle coûte forcément un certain prix à produire. Sans parler des années de développement que l'architecture Turing a demandé aux ingénieurs de Nvidia. Toujours sur le versant composant, il y a fort à parier que les modules GDDR6 (de marque Micron sur nos modèles de test) constituent aussi une ligne de dépense importante, au même titre que les nouvelles puces chargées de réguler la tension et la consommation des cartes (les VRM).

Puis vient le fameux système de refroidissement propre aux Founders Edition, qui s'est révélé très efficace et silencieux pendant toute cette première phase de test. Vu sa qualité de finition et de conception, il est certain que - là encore - Nvidia a dû dépenser quelques bonnes poignées de dollars pour arriver à un dispositif qui le satisfasse pleinement.

Tout cela nous permet donc, non pas de justifier aveuglement le tarif très élevé des RTX 2080 et 2080 Ti, mais de le mettre un peu plus en perspective. Oui, les RTX sont chères, plus onéreuses que les modèles GTX équivalents à leur sortie. Le modèle Founders Edition de la 2080 Ti est annoncé à presque 1260 euros quand la 2080 classique, elle, s’affiche à 850 euros.

Et les prix des cartes des partenaires affichent des prix bien plus élevés pour beaucoup d’entre elles : jusqu’à 1500 euros pour la RTX 2080 Ti et 1000 euros pour quelques RTX 2080. Toutes optent pour un dissipateur maison et quelques-unes voient leurs fréquences de fonctionnement dopées, permettant de justifier les centaines d’euros supplémentaires demandées.

Overclocking : le GPU Boost 4.0...

Les nouvelles RTX 2080 et RTX 2080 Ti sont, de l'aveu de Nvidia, aussi conçues pour permettre à tous les amateurs d'overclocking de s'en donner à coeur joie.

Les étages d'alimentation de cartes ont été repensés. Les fonctionnements de certains algorithmes ont été retravaillés et affinés et la puce aurait une meilleure tolérance aux montées en fréquences, notamment. Le père des GeForce a également deux nouvelles technologies à mettre aux services des overclockers.

Avec le GPU Boost 4.0, le concepteur donne maintenant accès aux algorithmes en charge de donner un coup de fouet au GPU tant que celui-ci n'atteint pas une certaine limite de température. Avec la version 3.0, lorsque le mercure crevait le plafond, la carte redescendait à ses fréquences d'origine. La 4.0 permet d'ajouter un palier intermédiaire lors de la descente en fréquences. Ainsi, la carte peut maintenir une vitesse de croisière un peu supérieure à celle de base, le temps que la température redescende. Si cela n'est pas le cas, et que le mercure atteint la valeur cible, le GPU reprend alors ses fréquences initiales.

... et le Nvidia Scanner

Pour tout ceux à qui l'overclocking paraît une science occulte mais qui souhaitent quand même pousser les RTX dans leur retranchement, Nvidia a créé un outil adapté (une API en fait), le Nvidia Scanner. Il est pour le moment accessible via l'outil Precision X1 de EVGA mais MSI ou encore Asus devraient le proposer aussi dans leur application maison.

Le principe de fonctionnement est simple, on agit sur quelques paramètres (fréquences, voltages, températures) et on lance un test d'évaluation. Ce dernier dure une vingtaine de minutes environ car les algorithmes vont mettre le GPU à l'épreuve et voir quelles sont les possibilités maximales qu'il peut atteindre. Si le test connaît des ratés, Scanner reprend la dernière bonne valeur boostée et harmonise ensuite seul la suite des montées en charge pour évaluer le meilleur "sweet spot". Malin, non ?

votre commentaire

votre commentaire

-

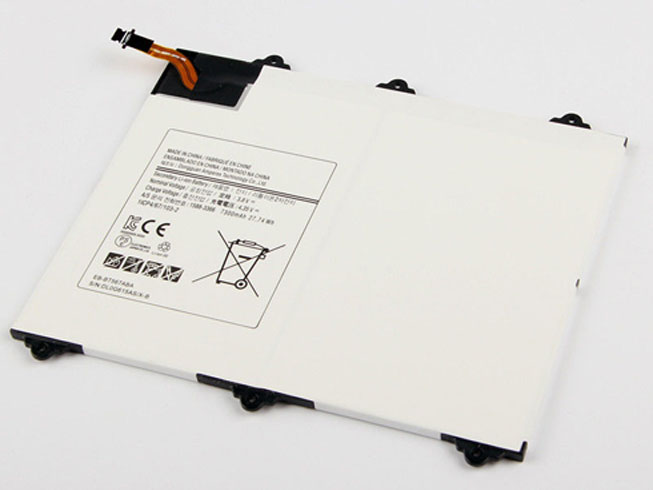

SAMSUNG EB-BT567ABA 7300MAH/27.74Wh 3.8V/4.35V batterie remplacement pour Samsung Galaxy Tab SM-T560NU T567v 9.6" au meilleur prix chez. EB-BT567ABA batterie pas cher ou batterie pc portable le plus performant, pour-batterie.com vous propose un large choix.

7300MAH/27.74Wh Samsung EB-BT567ABA Batterie pour Samsung Galaxy Tab SM-T560NU T567v 9.6"

- Capacité: 7300MAH/27.74Wh

- Tension: 3.8V/4.35V

Remplace les batteries suivantes:

Les Modèles Compatibles:

Samsung Galaxy Tab SM-T560NU SM-T567v 9.6"

La EB-BT567ABA batterie pour Samsung Galaxy Tab SM-T560NU T567v 9.6" est neuve et composée de cellules de qualité. Elle répond aux normes du constructeur dans la mesure où elle a : 1 an de garantie, Remboursement de 30 jours!

Sept conseils pour prolonger votre Samsung EB-BT567ABA batterie la vie.

1. Ne rechargez votre batterie notbook décharge de la batterie quand.

2. Tenter Li-ion Samsung EB-BT567ABA batterie pour Samsung Galaxy Tab SM-T560NU T567v 9.6" Il peut fonctionner pas longtemps que le Li-Ion une.

3. Gardez votre ordinateur portable défragmentation régulièrement pour prolonger la vie de la batterie d'ordinateur portable.

4. Utilisez un disque dur et lecteur optique spin-down des logiciels pour réduire la puissance de consumpition portable.

5. Lorsque longtemps sans utiliser d'ordinateur portable, Gardez-le en mode veille ou de sommeil. Il peut à la fois économiser l'énergie et étendre la 7300MAH/27.74Wh Samsung EB-BT567ABA batterie la vie.

6. Rangez votre Samsung EB-BT567ABA batterie dans un endroit frais et sec quand ne pas utiliser.

7. Si d'habitude vous garder votre portable branché en puissance fixe ou rarement. S'il vous plaît prendre vers le bas de votre 3.8V/4.35V Samsung EB-BT567ABA batterie. Si non, cela nuira à l'autonomie de la batterie.Désistement:

Les piles et les adaptateurs fournis par notre entreprise sont [remplacement pour] vendus pour être utilisés avec certains produits de fabricants d'ordinateurs, et toute référence à des produits ou des marques déposées de ces sociétés est uniquement dans le but d'identifier les fabricants d'ordinateurs avec lesquels nos produits [remplacement pour] peut être utilisé. Notre compagnie et ce site Web ne sont ni affiliés avec, autorisé par une licence par, les distributeurs pour, ni liées en aucune façon à ces fabricants d'ordinateurs, ni les produits proposés à la vente sur notre site Web fabriqués ou vendus avec l'autorisation des fabricants de les ordinateurs avec lesquels nos produits [remplacement pour] peuvent être utilisés.

votre commentaire

votre commentaire